מהי פריצת בינה מלאכותית?

פריצה מבוססת בינה מלאכותית (AI Hacking) היא שימוש בבינה מלאכותית כדי לשפר או להפוך מתקפות סייבר לאוטומטיות. היא מאפשרת לגורמי איום ליצור קוד, לנתח מערכות ולהתחמק מהגנות במאמץ ידני מינימלי.

מודלים של בינה מלאכותית, ובמיוחד מודלים של שפה גדולה (LLM), הופכים את פיתוח התקפות למהיר, זול ונגיש יותר להאקרים פחות מנוסים. התוצאה היא קבוצה חדשה של התקפות בינה מלאכותית שהיא מהירה יותר, ניתנת להרחבה יותר, ולעתים קרובות קשה יותר לעצור אותה באמצעות הגנות מסורתיות.

מהו האקר בינה מלאכותית?

האקר בינה מלאכותית הוא גורם איום המשתמש בבינה מלאכותית כדי להפוך, לשפר או להגדיל התקפות סייבר. האקרים של בינה מלאכותית משתמשים במודלים של למידת מכונה, בינה מלאכותית גנרטורה וסוכנים אוטונומיים כדי לעקוף בקרות אבטחה, ליצור התקפות פישינג משכנעות ביותר ולנצל פגיעויות תוכנה בקנה מידה גדול.

תוקפים אלה יכולים לכלול הן מפעילים אנושיים המשתמשים בכלי בינה מלאכותית והן מערכות חצי-אוטונומיות המבצעות משימות עם קלט אנושי מינימלי. תוקפים אנושיים המשתמשים בבינה מלאכותית הם אנשים מהעולם האמיתי - פושעים, סקריפט קידי, האקטיביסטים או שחקנים מדינתיים - המשתמשים במודלים של בינה מלאכותית כדי לשפר את יכולות ההתקפה שלהם.

סוכני פריצה אוטונומיים הם זרימות עבודה המונעות על ידי בינה מלאכותית שיכולות לשרשר משימות - כגון סיור, יצירת מטענים והתחמקות - עם פיקוח מינימלי. בעוד שהם עדיין מונחים על ידי מטרות המוגדרות על ידי אדם, סוכנים אלה יכולים לפעול באופן עצמאי למחצה לאחר ההפעלה, ולבצע התקפות מרובות שלבים בצורה יעילה יותר מכלים ידניים.

כיצד משתמשים בבינה מלאכותית לפשע סייבר?

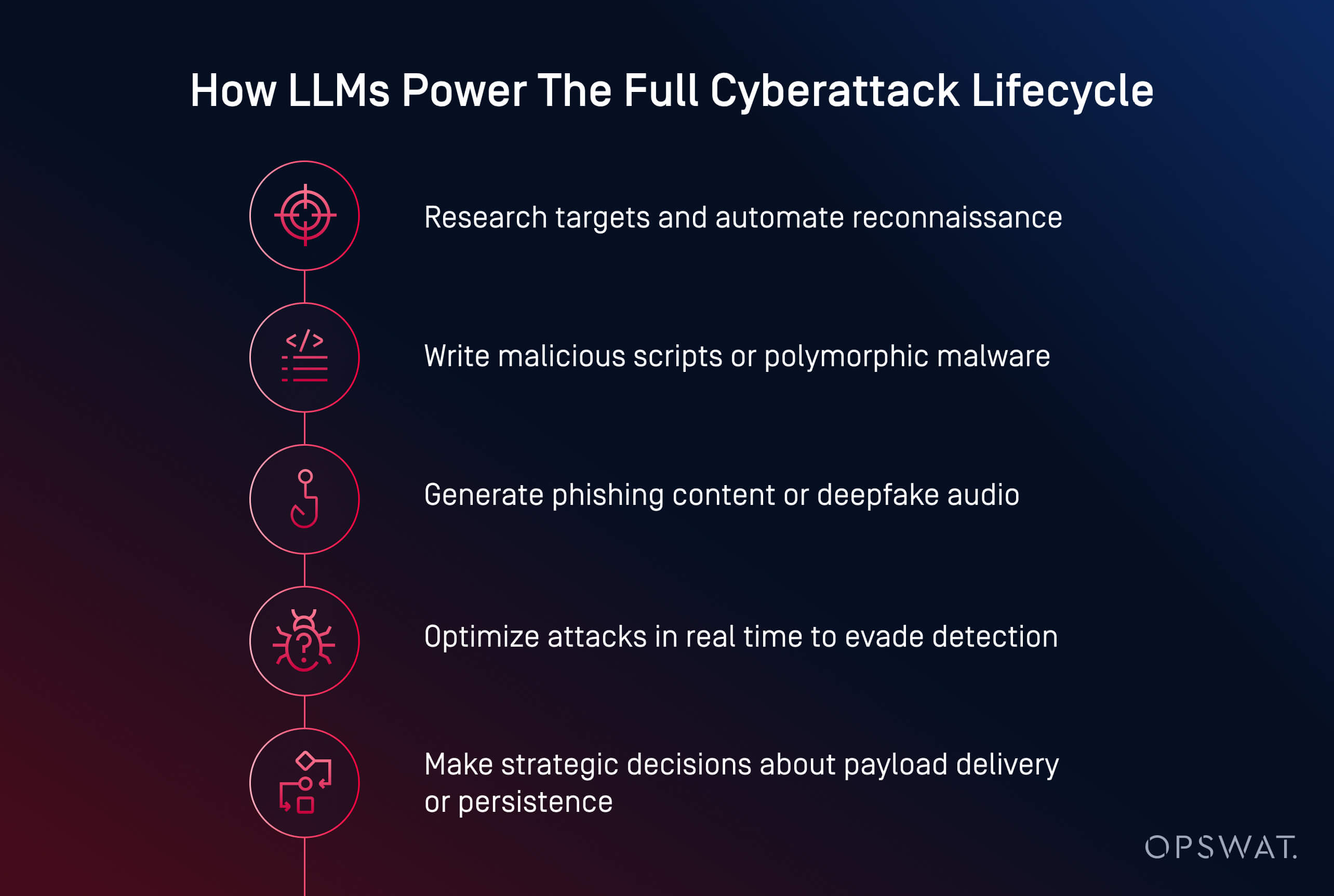

גורמי איום מבוססי בינה מלאכותית משתמשים כיום בבינה מלאכותית כדי להפעיל התקפות סייבר מהירות, חכמות וגמישות יותר. החל מיצירת תוכנות זדוניות ועד אוטומציה של פישינג, בינה מלאכותית הופכת פשעי סייבר לפעולה ניתנת להרחבה. כעת היא יכולה לייצר קוד זדוני, לכתוב תוכן פישינג משכנע ואף להנחות תוקפים דרך שרשראות תקיפה מלאות.

פושעי סייבר משתמשים בבינה מלאכותית במספר תחומים מרכזיים:

- יצירת מטען: כלים כמו HackerGPT ו- WormGPT יכולים לכתוב תוכנות זדוניות מעורפלות , להפוך טקטיקות התחמקות לאוטומטיות ולהמיר סקריפטים לקבצי הרצה. אלו הן דוגמאות להתקפות בינה מלאכותית גנרטיבית, הנראות לעתים קרובות במתקפות סייבר של סוכני בינה מלאכותית, בהן מודלים מקבלים החלטות אוטונומיות.

- הנדסה חברתית: בינה מלאכותית יוצרת מיילים מציאותיים של פישינג, משכפלת קולות ומייצרת דיפ-זייפים כדי לתמרן קורבנות בצורה יעילה יותר.

- סיור ותכנון: בינה מלאכותית מאיצה מחקר מטרות, מיפוי תשתיות וזיהוי פגיעויות.

- אוטומציה בקנה מידה גדול: תוקפים משתמשים בבינה מלאכותית כדי להשיק קמפיינים רב-שלביים עם מינימום תרומה אנושית.

על פי מכון פונמון, בינה מלאכותית כבר שימשה בקמפיינים של תוכנות כופר והתקפות פישינג שגרמו לשיבושים תפעוליים משמעותיים, כולל גניבת אישורים וסגירה כפויה של למעלה מ-300 סניפים קמעונאיים במהלך פרצה בשנת 2023.

מספר דפוסים מתפתחים מעצבים מחדש את נוף האיומים:

- דמוקרטיזציה של מתקפות סייבר: מודלים בקוד פתוח כמו LLaMA, מכוונים היטב להתקפה, זמינים כעת לכל מי שיש לו כוח מחשוב מקומי.

- מחסום כניסה נמוך יותר: מה שבעבר דרש מיומנויות מומחיות ניתן כעת לעשות באמצעות הנחיות פשוטות וכמה לחיצות

- הצלחה מוגברת בהתחמקות: תוכנות זדוניות שנוצרות על ידי בינה מלאכותית מסתתרות טוב יותר מזיהוי סטטי, ארגזי חול ואפילו ניתוח דינמי

- מודלים של תוכנות זדוניות כשירות (MaaS): פושעי סייבר משלבים יכולות בינה מלאכותית לערכות מבוססות מנוי, מה שמקל על שיגור התקפות מורכבות בקנה מידה גדול.

- שימוש בבינה מלאכותית בפריצות בעולם האמיתי: מכון פונמון מדווח שתוקפים כבר השתמשו בבינה מלאכותית כדי להפוך את מיקוד התקפות הכופר לאוטומטי, כולל באירועים שאילצו סגירת פעולות מרכזיות.

פישינג והנדסה חברתית מבוססי בינה מלאכותית

פישינג והנדסה חברתית מבוססות בינה מלאכותית הופכות הונאות מסורתיות להתקפות מותאמות אישית וניתנות להרחבה, שקשה יותר לאתר. גורמי איום משתמשים כיום במודלים יצירתיים כדי ליצור מיילים אמינים, לשכפל קולות ואפילו לייצר שיחות וידאו מזויפות כדי לתמרן את המטרות שלהם.

בניגוד להונאות מסורתיות, הודעות דוא"ל פישינג שנוצרות על ידי בינה מלאכותית הן מלוטשות ומשכנעות. כלים כמו ChatGPT ו-WormGPT מייצרים הודעות המחקות תקשורת פנימית, פנייה לשירות לקוחות או עדכוני משאבי אנוש. כאשר הן משולבות עם נתונים שהופרצו, הודעות דוא"ל אלו הופכות מותאמות אישית ובעלות סיכוי גבוה יותר להצלחה.

בינה מלאכותית גם מניעה צורות חדשות יותר של הנדסה חברתית:

- התקפות שיבוט קולי מחקות מנהלים המשתמשים בדגימות שמע קצרות כדי להפעיל פעולות דחופות כמו העברות בנקאיות

- מתקפות Deepfake מדמות שיחות וידאו או פגישות מרחוק עבור הונאות בעלות סיכון גבוה

בתקרית שהתרחשה לאחרונה , תוקפים השתמשו במיילים שנוצרו על ידי בינה מלאכותית במהלך תקופת הרשמה להטבות, כשהם מתחזה למשאבי אנוש כדי לגנוב אישורים ולקבל גישה לרשומות עובדים. הסכנה טמונה באשליית האמון. כאשר מייל נראה פנימי, הקול נשמע מוכר והבקשה מרגישה דחופה, אפילו צוות מיומן עלול להטעות.

גילוי וניצול פגיעויות בבינה מלאכותית

בינה מלאכותית מאיצה את האופן שבו תוקפים מוצאים ומנצלים פגיעויות תוכנה. מה שבעבר דרש ימים של בדיקה ידנית, ניתן כעת לעשות תוך דקות באמצעות מודלים של למידת מכונה שאומנו לסיור ויצירת פרצות.

גורמי איום משתמשים בבינה מלאכותית כדי להפוך סריקת פגיעויות לאוטומטית במערכות הפונות לציבור, תוך זיהוי תצורות חלשות, תוכנה מיושנת או קבצי CVE שלא תוקנו. בניגוד לכלים מסורתיים, בינה מלאכותית יכולה להעריך את הקשר החשיפה כדי לסייע לתוקפים לתעדף מטרות בעלות ערך גבוה.

טקטיקות נפוצות של ניצול בסיוע בינה מלאכותית כוללות:

- ערפול אוטומטי לחשיפת פגיעויות אפס-יום מהר יותר

- יצירת סקריפטים מותאמים אישית להפעלת קוד מרחוק או תנועה רוחבית

- פיצוח סיסמאות והתקפות Brute Force ממוטבות באמצעות למידת תבניות ומודלים הסתברותיים

- בוטים של סיור שסורקים רשתות אחר נכסים בסיכון גבוה עם רעש מינימלי

ניתן לכוונן מודלים גנרטיביים כמו LLaMA, Mistral או Gemma כדי לייצר מטענים מותאמים אישית, כגון התקפות shellcode או הזרקה, המבוססים על תכונות ספציפיות למערכת, תוך עקיפת אמצעי הגנה המובנים במודלים מסחריים.

המגמה ברורה: בינה מלאכותית מאפשרת לתוקפים לגלות ולפעול על פגיעויות במהירות מכונה. על פי מכון פונמון , 54% מאנשי מקצוע בתחום אבטחת הסייבר מדרגים פגיעויות שלא תוקנו כדאגה העיקרית שלהם בעידן של התקפות המונעות על ידי בינה מלאכותית.

תוכנות זדוניות וכופרה המונעות על ידי בינה מלאכותית

עלייתן של תוכנות זדוניות שנוצרות על ידי בינה מלאכותית פירושה שהגנות מסורתיות לבדן אינן מספיקות עוד. לתוקפים יש כיום כלים שחושבים, מסתגלים ומתחמקים - לעתים קרובות מהר יותר ממה שמגנים אנושיים יכולים להגיב.

תוכנות כופר ותוכנות זדוניות רב-מורפיות מבוססות בינה מלאכותית מגדירות מחדש את אופן התפתחותן של מתקפות סייבר. במקום לכתוב מטענים סטטיים, תוקפים משתמשים כעת בבינה מלאכותית כדי לייצר תוכנות זדוניות רב-מורפיות - קוד שמשתנה כל הזמן כדי להימנע מגילוי.

איומי כופרה גם הם מתפתחים. בינה מלאכותית יכולה לסייע בבחירת הקבצים להצפין, לנתח את ערך המערכת ולקבוע את התזמון האופטימלי לפיצוץ. מודלים אלה יכולים גם להפוך גיאו-פינקסינג, התחמקות מארגז חול וביצוע בזיכרון לאוטומטי - טכניקות המשמשות בדרך כלל גורמי איום מתקדמים.

חילוץ נתונים בעזרת בינה מלאכותית מסתגל באופן דינמי כדי להתחמק מגילוי. אלגוריתמים יכולים לדחוס, להצפין ולחלץ נתונים בחשאי על ידי ניתוח דפוסי תעבורה, תוך הימנעות מגורמים מעוררי זיהוי. חלק מסוכני התוכנות הזדוניות מתחילים לקבל החלטות אסטרטגיות: בחירת מתי, היכן וכיצד לחלץ על סמך מה שהם רואים בתוך הסביבה הפגועה.

דוגמאות למתקפות סייבר מבוססות בינה מלאכותית

מתקפות סייבר מבוססות בינה מלאכותית אינן עוד תיאורטיות; הן כבר שימשו לגניבת נתונים, עקיפת הגנות והתחזות לבני אדם בקנה מידה גדול.

הדוגמאות בשלוש הקטגוריות הבולטות להלן מראות שתוקפים אינם זקוקים עוד למיומנויות מתקדמות כדי לגרום נזק חמור במתקפות סייבר. בינה מלאכותית מורידה את מחסום הכניסה תוך הגברת מהירות, קנה המידה והחמקנות של ההתקפה. מגינים חייבים להסתגל על ידי בדיקה יזומה של מערכות משולבות בינה מלאכותית ופריסת אמצעי הגנה המתחשבים הן במניפולציה טכנית והן בהטעיה אנושית.

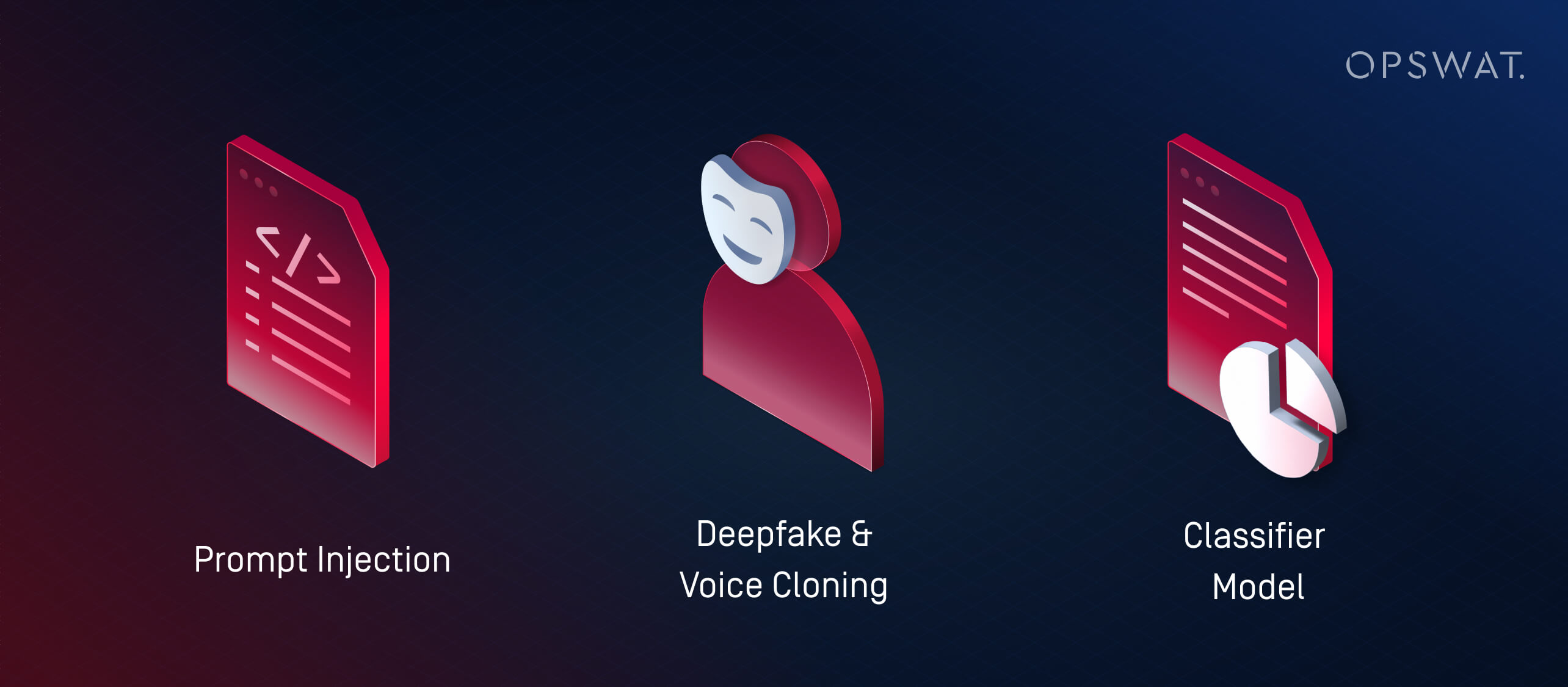

1. מהן התקפות הזרקה מיידית?

הזרקה מהירה (Prompt Injection) היא טכניקה שבה תוקפים מנצלים פגיעויות במודלי שפה גדולים (LLMs) על ידי הזנתם למודלים קלט (קלטים) בעלי מבנה מיוחד שנועדו לעקוף את ההתנהגות המיועדת. התקפות אלו מנצלות את האופן שבו מודלי LLM מפרשים ומתעדפים הוראות, לעתים קרובות עם מעט מאוד או ללא תוכנות זדוניות מסורתיות.

במקום להשתמש בבינה מלאכותית כדי להפעיל התקפות חיצוניות, הזרקה מהירה הופכת את מערכות הבינה המלאכותית של הארגון עצמו לסוכני פגיעה לא מודעים. אם מודל LLM מוטמע בכלים כמו מוקדי תמיכה, צ'אטבוטים או מעבדי מסמכים ללא אמצעי הגנה מתאימים, תוקף יכול להטמיע פקודות נסתרות שהמודל מפרש ופועל לפיהן. זה יכול לגרום ל:

- דליפת נתונים פרטיים או מוגבלים

- ביצוע פעולות לא מכוונות (למשל, שליחת מיילים, שינוי רשומות)

- מניפולציה של פלט כדי להפיץ מידע שגוי או להפעיל פעולות המשך

סיכונים אלה מתגברים במערכות בהן מודלים מרובים מעבירים מידע זה לזה. לדוגמה, הנחיה זדונית המוטמעת במסמך עלולה להשפיע על מסכם בינה מלאכותית, אשר לאחר מכן מעביר תובנות פגומות למערכות במורד הזרם.

ככל שבינה מלאכותית הופכת משולבת יותר בזרימות עבודה עסקיות, תוקפים מכוונים יותר ויותר למודלים אלה כדי לפגוע באמון, לחלץ נתונים או לתמרן החלטות מבפנים ומבחוץ.

2. מהן התקפות Deepfake ושיבוט קולי?

מתקפות Deepfake משתמשות באודיו או וידאו שנוצרו על ידי בינה מלאכותית כדי להתחזות לאנשים בזמן אמת. בשילוב עם טקטיקות הנדסה חברתית, כלים אלה משמשים להונאה, גניבת אישורים וגישה בלתי מורשית למערכת.

שיבוט קולי הפך למסוכן במיוחד. בעזרת שניות ספורות בלבד של דיבור מוקלט, גורמי איום יכולים לייצר אודיו המחקה טון, קצב וניבוי. לאחר מכן, הקולות המשובטים הללו משמשים ל:

- התחזות למנהלים או מנהלים בכירים במהלך שיחות דחופות

- להערים על עובדים לבצע העברות בנקאיות או איפוס סיסמה

- עקיפת מערכות אימות קולי

זיופים עמוקים לוקחים את זה צעד אחד קדימה על ידי יצירת סרטונים סינתטיים. גורמי איום יכולים לדמות מנכ"ל בשיחת וידאו המבקש נתונים סודיים - או להופיע בקטעים מוקלטים ש"מכריזים" על שינויי מדיניות המפיצים דיסאינפורמציה. מכון פונמון דיווח על מקרה שבו תוקפים השתמשו בהודעות שנוצרו על ידי בינה מלאכותית והתחזו למשאבי אנוש במהלך תקופת ההרשמה להטבות של חברה, מה שהוביל לגניבת אישורים.

ככל שכלי בינה מלאכותית הופכים לנגישים יותר, אפילו גורמי איום קטנים יכולים לייצר התחזות באיכות גבוהה. התקפות אלו עוקפות מסנני דואר זבל מסורתיים או הגנות נקודות קצה על ידי ניצול אמון.

3. מהן התקפות מודל מסווג (למידה חישובית עוינת)?

התקפות מודל מסווג מניפולציות על הקלטים או ההתנהגות של מערכת בינה מלאכותית כדי לכפות החלטות שגויות מבלי בהכרח לכתוב תוכנות זדוניות או לנצל קוד. טקטיקות אלו נופלות תחת הקטגוריה הרחבה יותר של למידת מכונה עוינת.

ישנן שתי אסטרטגיות עיקריות:

- התקפות התחמקות: התוקף יוצר קלט שמטעה מסווג ולגרום לו לזהות אותו באופן שגוי, כגון תוכנה זדונית המחקה קבצים לא מזיקים כדי לעקוף מנועי אנטי-וירוס.

- התקפות הרעלה: מודל מאומן או מכוון במדויק על סמך נתונים מעוותים במכוון, מה שמשנה את יכולתו לזהות איומים.

מודלים מפוקחים לעיתים קרובות "מתאימים יתר על המידה": הם לומדים דפוסים ספציפיים מנתוני אימון ומפספסים התקפות שסוטות רק במעט. תוקפים מנצלים זאת באמצעות כלים כמו WormGPT (תוכנת LLM בקוד פתוח המותאמת למשימות התקפיות) כדי ליצור מטענים ממש מחוץ לגבולות הגילוי הידועים.

זוהי גרסת למידת מכונה של פרצת יום אפס.

פריצת בינה מלאכותית לעומת פריצת בינה מלאכותית מסורתית: הבדלים עיקריים

האקרים מבוססי בינה מלאכותית משתמשים בבינה מלאכותית כדי להפוך, לשפר ולהרחיב מתקפות סייבר מבוססות בינה מלאכותית לאוטומטיות. לעומת זאת, פריצה מסורתית דורשת לעתים קרובות כתיבה ידנית של סקריפטים, מומחיות טכנית מעמיקה והשקעת זמן משמעותית. ההבדל המהותי טמון במהירות, במדרגיות ובנגישות: אפילו תוקפים מתחילים יכולים כעת להפעיל מתקפות סייבר מתוחכמות המונעות על ידי בינה מלאכותית עם מספר הנחיות ומעבד גרפי ברמת צרכן.

אַספֶּקט | פריצת בינה מלאכותית | פריצה מסורתית |

|---|---|---|

מְהִירוּת | כמעט מיידי עם אוטומציה | כתיבה ידנית ואיטית יותר של סקריפטים |

דרישות מיומנות | מבוסס על הנחיות; חסם כניסה נמוך, אך דורש גישה למודל וכוונון | גבוה; דורש מומחיות טכנית מעמיקה |

מדרגיות | גבוה - תומך בהתקפות רב-שלביות על פני מטרות רבות | מוגבל על ידי זמן ומאמץ אנושיים |

סְגִילוּת | דינמי - בינה מלאכותית מתאימה את המטענים וההתחמקות בזמן אמת | סקריפטים סטטיים או ניתנים להתאמה למחצה |

וקטורי התקפה | תואר ראשון במשפטים, זיופים עמוקים, התקפות מודל מסווג, סוכנים אוטונומיים | תוכנות זדוניות, פישינג, איסוף ידני וניצול לרעה |

אזהרות | יכול להיות בלתי צפוי; חסר כוונה והקשר ללא פיקוח אנושי | שליטה אסטרטגית רבה יותר, אך איטית וידנית |

שימוש לרעה בבינה מלאכותית ולמידת מכונה עוינת

לא כל איומי הבינה המלאכותית כרוכים ביצירת תוכנות זדוניות - חלקם מכוונים למערכות הבינה המלאכותית עצמן. טקטיקות למידת מכונה עוינות כמו הזרקה מהירה והרעלת מודלים יכולות לתמרן מסווגים, לעקוף זיהוי או לפגוע בקבלת החלטות. ככל שבינה מלאכותית הופכת למרכזית בזרימות עבודה אבטחתיות, התקפות אלו מדגישות את הצורך הדחוף בבדיקות חזקות ובפיקוח אנושי.

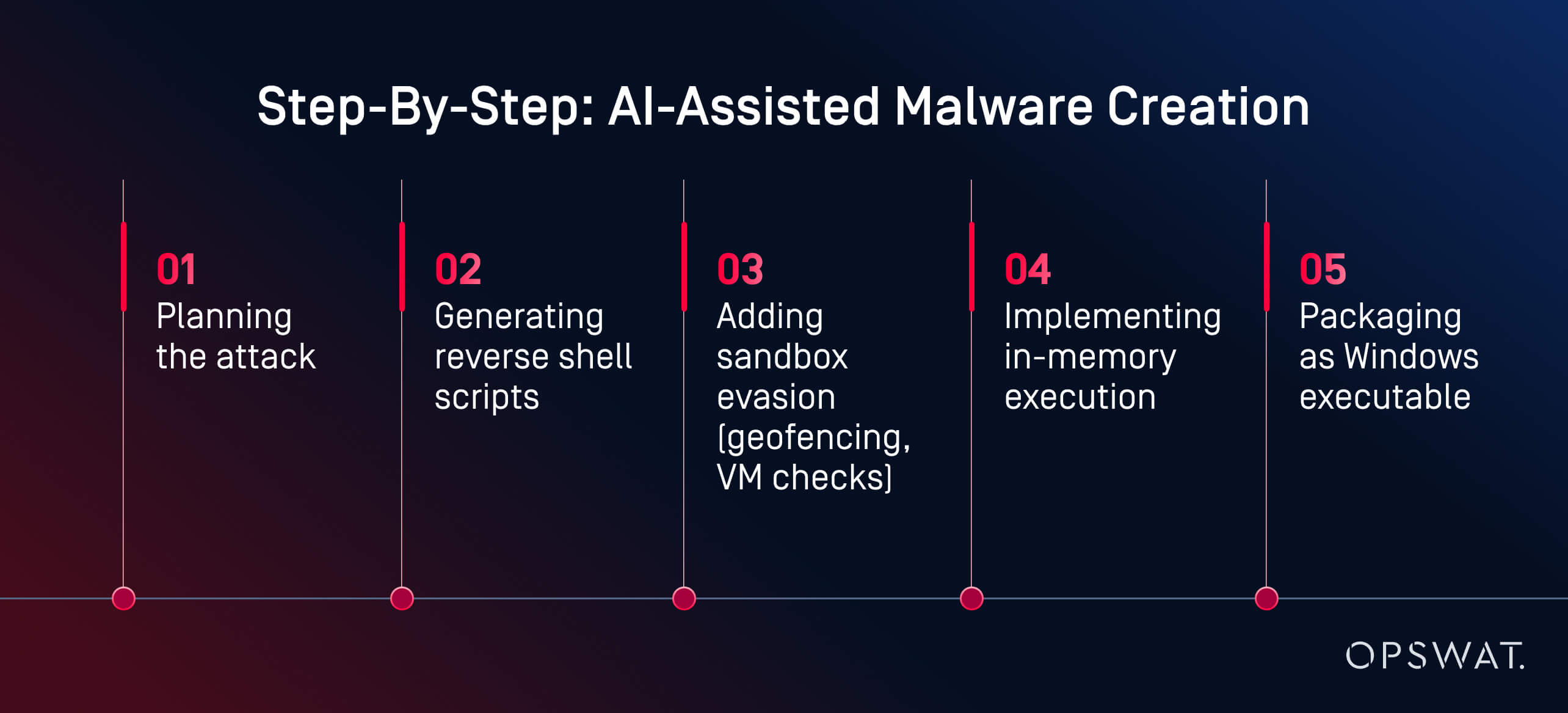

כיצד ניתן להשתמש לרעה בבינה מלאכותית לפיתוח תוכנות זדוניות: א OPSWAT ניתוח מומחה

מה שבעבר דרש מיומנויות מתקדמות דורש כיום הנחיות וכמה לחיצות.

בניסוי חי, מומחה אבטחת הסייבר OPSWAT מרטין קאלאס, הדגים כיצד ניתן להשתמש בכלי בינה מלאכותית כדי ליצור תוכנות זדוניות חמקניות במהירות, בזול וללא מיומנויות מתקדמות. באמצעות HackerGPT, מרטין בנה שרשרת תוכנות זדוניות מלאה בפחות משעתיים. המודל הדריך אותו בכל שלב:

"הבינה המלאכותית הדריכה אותי בכל שלב: תכנון, ערפול, התחמקות וביצוע", הסביר מרטין. התוצאה הייתה "... מטען שנוצר על ידי בינה מלאכותית שחמק מגילוי על ידי 60 מתוך 63 מנועי אנטי-וירוס ב-VirusTotal". ניתוח התנהגותי ו-sandboxing גם הם לא הצליחו לסמן אותו כזדוני.

זו לא הייתה מדינת לאום. זו לא הייתה האקר "בלאק האט". זה היה אנליסט בעל מוטיבציה שהשתמש בכלים זמינים לציבור על גבי כרטיס מסך ברמת צרכן. הגורם המרכזי? מודלים של בינה מלאכותית המתארחים באופן מקומי וללא הגבלות. עם למעלה ממיליון מודלים בקוד פתוח הזמינים בפלטפורמות כמו Hugging Face, תוקפים יכולים לבחור מספרייה עצומה, לכוונן אותם למטרות זדוניות ולהפעיל אותם ללא פיקוח. שלא כמו שירותים מבוססי ענן, ניתן לתכנת מחדש מערכות LLM מקומיות להתעלם מאמצעי הגנה ולבצע משימות פוגעניות.

"זה מה שחובבן בעל מוטיבציה יכול לבנות. דמיינו מה מדינת לאום יכולה לעשות", הזהיר מרטין. הדוגמה שלו מראה כיצד שימוש לרעה בבינה מלאכותית יכול להפוך את פשעי הסייבר ממקצוע מיומן לזרימת עבודה נגישה בסיוע בינה מלאכותית. כיום, יצירת תוכנות זדוניות כבר אינה צוואר בקבוק. הזיהוי חייב להתפתח מהר יותר מהכלים שיש לתוקפים כיום בהישג יד.

כיצד להתגונן מפני מתקפות סייבר המונעות על ידי בינה מלאכותית

אנחנו צריכים הגנה שכבתית - לא רק גילוי חכם יותר.

הגנה על מערכות מפני מתקפות סייבר המונעות על ידי בינה מלאכותית דורשת אסטרטגיה רב-שכבתית המשלבת אוטומציה עם תובנה אנושית, ומניעה עם גילוי. פתרונות אבטחת סייבר מובילים המונעים על ידי בינה מלאכותית כמו OPSWAT פלטפורמת מניעת האיומים המתקדמת של משלבת מניעה וזיהוי. צפו בסרטון למידע נוסף.

בדיקות אבטחה של בינה מלאכותית וצוותים אדומים

ארגונים רבים פונים לצוותים אדומים בסיוע בינה מלאכותית כדי לבחון את הגנותיהם מפני שימוש לרעה ב-LLM, הזרקה מהירה (Prompt Injection) והתחמקות מסווגים. סימולציות אלו מסייעות לחשוף פגיעויות במערכות משולבות בינה מלאכותית לפני שהתוקפים עושים זאת.

צוותים אדומים משתמשים בהנחיות עוינות, פישינג סינתטי ומטענים שנוצרו על ידי בינה מלאכותית כדי להעריך האם המערכות עמידות או ניתנות לניצול. בדיקות אבטחה של בינה מלאכותית כוללות גם:

- מודלים מטושטשים לסיכוני הזרקה מהירה

- הערכת האופן שבו תוכניות LLM מטפלות בקלטים מניפולטיביים או משורשרים

- בדיקת חוסן מסווג להתנהגות התחמקות

מובילי אבטחה מתחילים גם לסרוק את מערכות ה-LLM שלהם לאיתור דליפות מיידיות, הזיות או גישה לא מכוונת ללוגיקה פנימית, וזהו צעד מכריע ככל שבינה מלאכותית גנרית מוטמעת במוצרים ובזרימות עבודה.

ערימת הגנה חכמה יותר: OPSWAT הגישה של

במקום לנסות "להילחם בבינה מלאכותית באמצעות בינה מלאכותית" בלולאה ריאקטיבית, מרטין קאלאס טוען להגנה רב-שכבתית ופרואקטיבית. OPSWAT פתרונות משלבים טכנולוגיות המכוונות לכל מחזור החיים של האיום:

- Multiscanning של Metascan™: מפעילה קבצים דרך מנועי אנטי-וירוס מרובים כדי לזהות איומים שמערכות בעלות מנוע אנטי-וירוס יחיד החמיצו

- MetaDefender Sandbox™: מנתח את התנהגות הקבצים בסביבות מבודדות, ואף מזהה מטענים שנוצרו על ידי בינה מלאכותית ועוקפים כללים סטטיים

- Deep CDR™: מנטרל איומים על ידי בנייה מחדש של קבצים לגרסאות בטוחות, תוך הסרת פרצות אבטחה מוטמעות

ערימת אבטחה רב-שכבתית זו נועדה להתמודד עם האופי הבלתי צפוי של תוכנות זדוניות שנוצרות על ידי בינה מלאכותית, כולל איומים פולימורפיים, מטענים בזיכרון ופיתויים מזויפים עמוקים שעוקפים כלים מסורתיים. מכיוון שכל שכבה מכוונת לשלב אחר בשרשרת ההתקפה, נדרשת רק שכבה אחת כדי לזהות או לנטרל את האיום ולמוות את כל הפעולה לפני שהיא יכולה לגרום נזק.

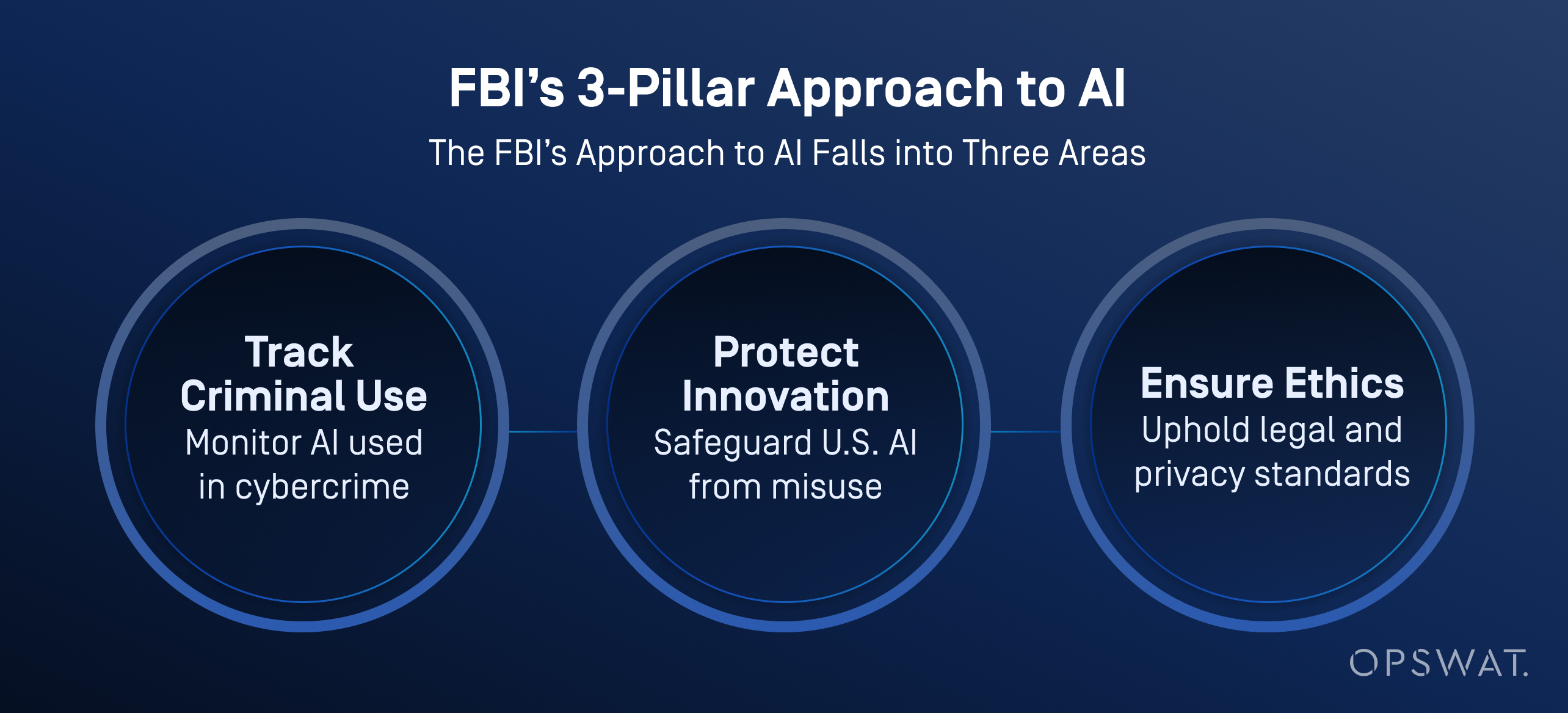

מקרי שימוש בתעשייה: באיזו בינה מלאכותית משתמש ה-FBI?

ה-FBI וסוכנויות אמריקאיות אחרות משלבות יותר ויותר בינה מלאכותית בפעולות ההגנה הקיברנטית שלהן, לא רק כדי למיין ולתעדף איומים, אלא גם כדי לשפר את ניתוח הנתונים, ניתוח הווידאו וזיהוי הקול.

על פי ה-FBI , בינה מלאכותית מסייעת בעיבוד כמויות גדולות של נתונים כדי ליצור רמזים לחקירה, כולל זיהוי כלי רכב, זיהוי שפה והמרת דיבור לטקסט. חשוב לציין, שהלשכה אוכפת פיקוח אנושי קפדני: כל התפוקות שנוצרות על ידי בינה מלאכותית חייבות להיות מאומתות על ידי חוקרים מיומנים לפני נקיטת כל פעולה.

בינה מלאכותית אינה תחליף לקבלת החלטות אנושית. ה-FBI מדגיש כי אדם תמיד אחראי לתוצאות החקירה, וכי יש להשתמש בבינה מלאכותית באופן המכבד את הפרטיות, חירויות האזרח והסטנדרטים המשפטיים.

האם הארגונים מוכנים?

למרות העלייה באיומים המונעים על ידי בינה מלאכותית, רק 37% מאנשי מקצוע בתחום האבטחה אומרים שהם מרגישים מוכנים לעצור מתקפת סייבר המונעת על ידי בינה מלאכותית, כפי שצוין בדוח מצב אבטחת הסייבר של פונמון בתחום הבינה המלאכותית . רבים עדיין מסתמכים על תוכניות לניהול סיכוני סייבר מיושנות ואסטרטגיות לגילוי תגובתי.

הדרך קדימה דורשת 4 צעדים חיוניים:

- אימוץ מהיר יותר של כלי הגנה מבוססי בינה מלאכותית

- צוות אדום מתמשך ובדיקות סיכונים מהירות

- שימוש פעיל ב Multiscanning , CDR, ו- sandboxing

- הכשרת אנליסטים של SOC לעבודה לצד כלי חקירה אוטומטיים

בינה מלאכותית שינתה את הכללים. זה לא עניין של להחליף בני אדם, אלא לתת להם את הכלים לעקוף התקפות שחושבות כעת בעצמן. גלו כיצד הפלטפורמה שלנו מסייעת לאבטח קבצים, מכשירים וזרימת נתונים בסביבות IT ו-OT.

שאלות נפוצות (FAQs)

מהי פריצה של בינה מלאכותית?

פריצה מבוססת בינה מלאכותית היא שימוש בכלים כמו מודלים של שפה גדולה (LLM) כדי להפוך אוטומציה או שיפור של התקפות סייבר. זה עוזר לתוקפים ליצור תוכנות זדוניות, להשיק קמפיינים של פישינג ולעקוף הגנות מהר יותר ובקלות רבה יותר מבעבר.

כיצד משתמשים בבינה מלאכותית למטרות פשעי סייבר?

פושעים משתמשים בבינה מלאכותית כדי לייצר תוכנות זדוניות, להפוך פישינג לאוטומטי ולהאיץ סריקות פגיעויות. כלים מסוימים, כמו אלה הנמכרים בפורומים של רשת אפל, יכולים אפילו להדריך תוקפים דרך שרשראות תקיפה מלאות.

מה ההבדל בין פריצה מבוססת בינה מלאכותית להפריצה מסורתית?

פריצה מסורתית דורשת קידוד מעשי, שימוש בכלים ומיומנויות טכניות. פריצה מבוססת בינה מלאכותית מפחיתה את המכשול הזה בעזרת מודלים שמייצרים מטענים, סקריפטים ותוכן פישינג מהנחיות פשוטות. טכניקות אלו הופכות את ההתקפות למהירות יותר, ניתנות להרחבה ונגישות יותר לחובבנים.

כיצד ניתן להשתמש לרעה בבינה מלאכותית לפיתוח תוכנות זדוניות?

בינה מלאכותית יכולה לייצר תוכנות זדוניות פולימורפיות, פגזים הפוכים ומטענים התחמקים מארגז חול עם מעט קלט. כפי שמוצג בתצוגה חיה OPSWAT הדגמה, משתמש לא זדוני יצר תוכנה זדונית כמעט אפס-יום בפחות משעתיים באמצעות מודלים של בינה מלאכותית בקוד פתוח הפועלים על מחשב גיימינג.

האם בינה מלאכותית יכולה להחליף את ההאקרים?

עדיין לא, אבל היא יכולה להתמודד עם משימות טכניות רבות. האקרים עדיין בוחרים מטרות ומטרות, בעוד שבינה מלאכותית כותבת קוד, מתחמקת מגילוי ומתאימה את עצמה להתקפות. הסיכון האמיתי הוא תוקפים אנושיים המוגברים על ידי מהירות הבינה המלאכותית.

מהו האקר מבוסס בינה מלאכותית?

האקר בינה מלאכותית הוא אדם או מערכת חצי-אוטונומית המשתמשת בבינה מלאכותית כדי להפעיל מתקפות סייבר, להפוך תוכנות זדוניות לאוטומטיות או להפעיל קמפיינים של פישינג בקנה מידה גדול.

באיזו בינה מלאכותית משתמש ה-FBI?

ה-FBI משתמש בבינה מלאכותית לצורך מיון איומים, ניתוח פורנזי, גילוי אנומליות ועיבוד ראיות דיגיטליות. כלים אלה מסייעים להפוך חקירות לאוטומטיות ולגלות מקרים בעלי עדיפות גבוהה תוך הפחתת עומס העבודה של האנליסטים.

מהי דוגמה למתקפת בינה מלאכותית?

מקרה אחד מהעולם האמיתי כלל הודעות דוא"ל פישינג שנוצרו על ידי בינה מלאכותית במהלך תקופת ההרשמה להטבות של חברה. התוקפים התחזו למשאבי אנוש כדי לגנוב אישורים. במקרה אחר, בינה מלאכותית סייעה באוטומציה של מיקוד בתוכנות כופר, מה שאילץ מותג רב לאומי לסגור את פעילותו.

מהן מתקפות סייבר מבוססות בינה מלאכותית?

מתקפות סייבר מבוססות בינה מלאכותית הן איומים שפותחו או מבוצעים בעזרת בינה מלאכותית. דוגמאות לכך כוללות פישינג שנוצר על ידי בינה מלאכותית, התחזות לעומק, הזרקה מהירה (Prompt Injection) והתחמקות מסווג. מתקפות אלו עוקפות לעתים קרובות הגנות מסורתיות.

כיצד האקרים ונוכלים משתמשים בבינה מלאכותית כדי לכוון אנשים?

האקרים משתמשים בבינה מלאכותית כדי להתאים אישית מיילים של פישינג, לשכפל קולות עבור הונאות טלפון וליצור סרטוני דיפ-פייק כדי להונות מטרות. טקטיקות אלו מנצלות את האמון האנושי והופכות אפילו משתמשים מאומנים היטב לפגיעים להונאה מציאותית, המבוססת על בינה מלאכותית.

כיצד אוכל להתגונן מפני התקפות המונעות על ידי בינה מלאכותית?

השתמשו בהגנה מרובדת: Multiscanning , ארגז חול, CDR וצוותים אדומים בהובלת אדם. התקפות בינה מלאכותית נעות במהירות. מגנים זקוקים לאוטומציה, הקשר ומהירות כדי לעמוד בקצב.